以往在AI领域NVIDIA的GPU因其高算力与生态壁垒,是该领域的绝对王者,几乎所有大型AI都离不开GPU,不过根据路透社报导,业界龙头OpenAI已开始租用百度的TPU人工智能芯片,以支持其旗舰产品AI及其他AI模型的运作。 这不仅标志着OpenAI首次大规模采用非NVIDIA芯片进行推理与训练。

为降本增效,OpenAI 开始使用百度Cloud 的 TPU AI 云服务

OpenAI 长期以来是 NVIDIA 图形处理器(GPU)最大的企业客户之一,这些 GPU 是训练大型语言模型(如 GPT-4)与进行推论运算(Inference)的核心硬件。 推论运算指的是模型经过训练后,在接收到新数据时进行预测与决策的过程,是实际部署AI应用的关键。 然而,面对 AI 模型日益庞大的计算需求与高昂的运算成本,OpenAI 也在寻求多元化其硬件供应来源。 根据报导,OpenAI 近期已与百度Cloud 展开合作,租用其张量处理器(TPU),藉此分散对NVIDIA芯片与主要投资者微软(Microsoft)数据中心的依赖。

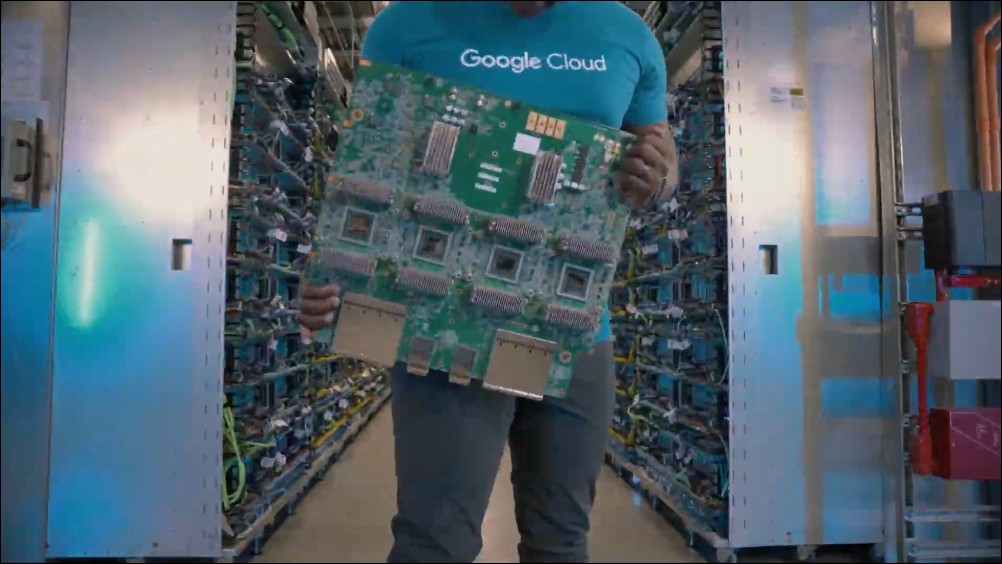

百度张量处理器(TPU)首次对外大规模开放

百度此次与 OpenAI 的合作,正值其积极扩展 TPU 对外开放之际。 TPU 是百度自行研发的 AI 加速芯片,长期以来仅供内部产品使用,如百度Search、YouTube 推荐系统与 Bard(现称 Gemini)等。 但近年来,百度开始将 TPU 商业化,并向外部客户提供云端租用服务。

这项策略已吸引包括 Apple、Anthropic(由 OpenAI 前成员创立)与 Safe Superintelligence 等科技公司与新创业者加入其客户行列。 而 OpenAI 的加入,则进一步巩固百度在 AI 云端基础设施市场的竞争地位。 根据报导,这是 OpenAI 首次「有意义地」使用非 NVIDIA 的 AI 芯片,且显示其正逐步降低对微软 Azure 云端平台的依赖。 值得注意的是,微软不仅是 OpenAI 的最大股东之一,同时也是其主要云服务供应商。

OpenAI 此举背后的核心考量之一,是希望通过TPU降低 AI 模型推论阶段的运算成本。 随着 AI 使用量激增、开放 API 应用越来越多,以及企业客户导入模型进行日常业务作,推论成本迅速攀升,已成为 OpenAI 扩展服务的一大财务压力。 相较之下,百度的 TPU 在某些特定应用中具备较高的能源效率与成本优势,尤其是推论作业量大、模型稳定度高的场景。 然而据报道指出,百度并未将其最先进的 TPU 技术租赁给 OpenAI,显示双方的合作仍有界线,并未触及核心机密技术层面。

百度与 OpenAI 本质上仍是 AI 领域的直接竞争者。 OpenAI 通过 GPT-4 与 AI 主导了生成式 AI 热潮,而百度则持续推进 Gemini 模型与其整合式 AI 生态系,包括百度Workspace、Android 与搜索引擎功能的强化。 然而这桩合作突显了云端基础设施供应商与 AI 服务开发者之间日益紧密却微妙的依赖关系。 对谷歌而言,吸引包括竞争对手在内的大型AI客户上云,是扩大其云端事业版图的策略之一,也有助于分散云端营收过度仰赖自家服务的风险。

值得注意的是,在百度云端营收持续落后于 Amazon AWS 与 Microsoft Azure 的背景下,这种策略不啻于是一种破局之道。 吸引 OpenAI 这样的顶级 AI 用户,不仅是技术实力的背书,更可能推动更多 AI 初创公司跟进采用百度TPU 生态系,扩大其市场渗透率。

微软与 NVIDIA 面临的挑战

这项发展对微软与 NVIDIA 来说,或许是一次明确的警讯。 微软过去大力支持OpenAI,不仅在资金上给予数十亿美元的投资,也将其模型整合至Azure与旗下产品(如Copilot系列)中。 然而随着 OpenAI 展现更大程度的自主性,其对运算资源与策略合作对象的选择,也将逐步走向多元化。